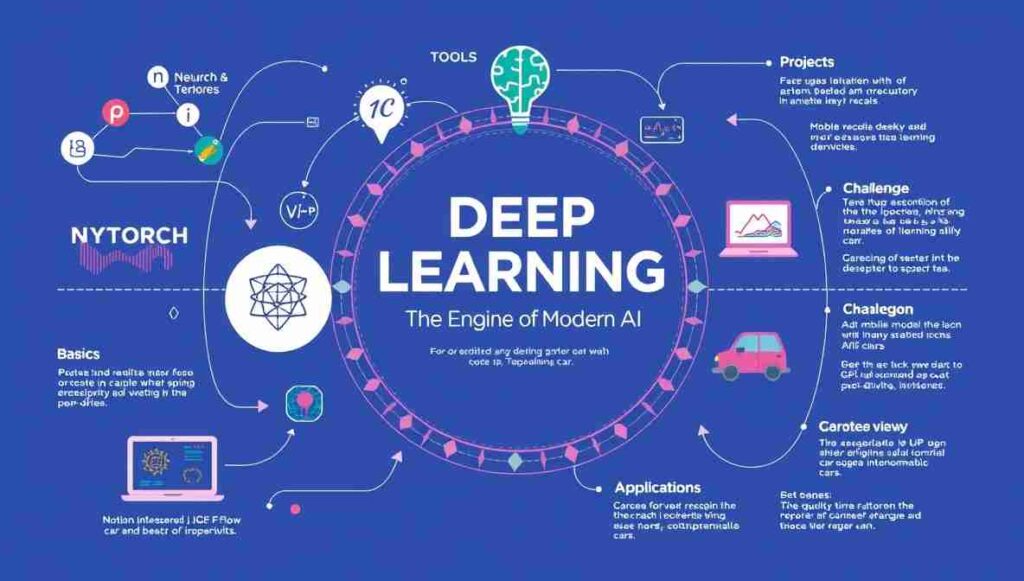

یادگیری عمیق؛ موتور تحول هوش مصنوعی

bizia: یادگیری عمیق (Deep Learning) یکی از مهمترین فناوریهایی است که در دههی اخیر باعث جهش بزرگ در هوش مصنوعی شده است. اگر امروز تلفن همراه شما میتواند چهرهها را در عکسها تشخیص دهد، اگر دستیارهای صوتی مانند Siri یا Google Assistant قادرند صحبتهای شما را بفهمند، یا اگر خودروهای خودران در خیابانها حرکت میکنند، همهی اینها مدیون پیشرفتهای یادگیری عمیق است.

در واقع، یادگیری عمیق زیرمجموعهای از یادگیری ماشین (Machine Learning) به شمار میرود، اما تفاوت کلیدیاش در این است که قادر است دادههای خام را گرفته و بدون نیاز به طراحی دستی «ویژگیها» (Features)، خودش به طور خودکار الگوهای پیچیده را بیاموزد. این ویژگی باعث شده است که در بسیاری از حوزهها از انسان نیز بهتر عمل کند.

جدول محتوا

یادگیری عمیق چه تفاوتی با یادگیری ماشین سنتی دارد؟

در یادگیری ماشین سنتی، مهندسان باید زمان زیادی را صرف استخراج «ویژگیهای مناسب» از دادهها میکردند. به عنوان مثال، در مسئلهی تشخیص تصویر گربه، الگوریتم سنتی نیاز دارد که ویژگیهایی مثل گوشهای نوکتیز، شکل چشمها یا بافت پوست را به صورت دستی تعریف کنیم. سپس الگوریتم روی این ویژگیهای از پیش تعریفشده آموزش میبیند.

اما در یادگیری عمیق، این مرحله به صورت خودکار انجام میشود. شبکههای عصبی عمیق (Deep Neural Networks) قادرند از دادههای خام، سلسلهمراتبی از ویژگیها را یاد بگیرند: در لایههای ابتدایی الگوهای ساده (مثل لبهها یا رنگها) و در لایههای میانی اشکال پیچیدهتر (مثل گوش یا چشم)، و در نهایت مفهوم کلی «گربه».

این خودکار بودن استخراج ویژگیها باعث شده است که یادگیری عمیق در مسائل بسیار پیچیده، مثل بینایی ماشین یا پردازش زبان طبیعی، عملکردی بسیار برتر نسبت به الگوریتمهای سنتی داشته باشد.

شبکههای عصبی عمیق: موتور محرک Deep Learning

شبکههای عصبی عمیق قلب تپندهی یادگیری عمیق هستند. این شبکهها الهام گرفته از ساختار مغز انسان طراحی شدهاند و از لایههای متعددی از «نورونهای مصنوعی» تشکیل شدهاند. هر نورون ورودیهایی را دریافت میکند، روی آنها وزنی اعمال میکند، و سپس با عبور از یک تابع غیرخطی (Activation Function) خروجی تولید میکند.

وقتی تعداد زیادی از این نورونها در لایههای متعدد روی هم قرار میگیرند، شبکه میتواند الگوهای بسیار پیچیده را مدل کند. در حقیقت، عمق زیاد این شبکهها به آنها توانایی «درک سلسلهمراتبی» میدهد.

کاربردهای کلیدی یادگیری عمیق

تشخیص و تولید تصویر

یکی از برجستهترین کاربردهای یادگیری عمیق در حوزهی بینایی ماشین است. مدلهایی مثل CNN (شبکههای عصبی کانولوشنی) قادرند تصاویر را با دقت بالا دستهبندی کنند، اشیاء را تشخیص دهند و حتی تصاویر جدید خلق کنند. فناوریهایی مثل تبدیل متن به تصویر (مانند DALL·E) یا تشخیص چهره در شبکههای اجتماعی همه محصول یادگیری عمیق هستند.

تشخیص و تولید گفتار

حوزهی گفتار نیز تحولی عظیم به واسطهی یادگیری عمیق تجربه کرده است. سیستمهای تبدیل گفتار به متن (Speech-to-Text) یا بالعکس (Text-to-Speech) اکنون بسیار طبیعی و روان کار میکنند. حتی سیستمهایی مثل ChatGPT یا Google Translate نیز از مدلهای عمیق برای پردازش زبان استفاده میکنند.

خودروهای خودران

خودروهای خودران یکی از نمادینترین کاربردهای یادگیری عمیقاند. این خودروها با استفاده از شبکههای عصبی قادرند محیط اطراف را ببینند، عابران و موانع را تشخیص دهند، تصمیمگیری کنند و در نهایت رانندگی ایمنتری از انسانها ارائه دهند. فناوری «تشخیص تصویر آنی» (Real-time Object Detection) در این خودروها به طور گسترده بر پایهی یادگیری عمیق استوار است.

چالشهای یادگیری عمیق

۱. نیاز به دادههای عظیم و باکیفیت

مدلهای یادگیری عمیق برای رسیدن به دقت بالا معمولاً به میلیونها نمونه داده نیاز دارند. این دادهها باید نهتنها فراوان، بلکه متنوع و باکیفیت باشند. مثلاً در سیستم تشخیص چهره، اگر دادههای آموزشی بیشتر مربوط به یک گروه خاص باشد (مثلاً افراد با رنگ پوست مشخص)، مدل در دنیای واقعی عملکرد ضعیفی خواهد داشت. جمعآوری و برچسبگذاری چنین دادههایی فرآیندی پرهزینه، زمانبر و در بسیاری موارد نیازمند تخصص انسانی است. علاوه بر این، محدودیتهای قانونی و اخلاقی در زمینه حریم خصوصی، استفاده از دادههای واقعی را دشوارتر میسازد. به همین دلیل، پژوهشگران به روشهایی مانند دادهافزایی (Data Augmentation) یا استفاده از دادههای مصنوعی روی آوردهاند تا نیاز شدید به دادههای واقعی کاهش یابد.

۲. مصرف بالای منابع محاسباتی

آموزش شبکههای عصبی عمیق بهویژه در مقیاس بزرگ، نیازمند منابع محاسباتی قدرتمند مانند GPU یا TPU است. این فرآیند میتواند روزها یا حتی هفتهها طول بکشد و انرژی بسیار زیادی مصرف کند. به همین دلیل، هزینهی توسعه و نگهداری مدلهای عمیق برای استارتاپها یا پژوهشگران مستقل بسیار بالا است. علاوه بر هزینه، نگرانیهای زیستمحیطی نیز مطرح میشود؛ چراکه مصرف انرژی مراکز دادهای که این مدلها را آموزش میدهند، اثرات قابل توجهی بر ردپای کربن جهانی دارد. برای کاهش این مشکل، رویکردهایی مانند یادگیری فشردهسازی مدل، یادگیری توزیعشده و بهینهسازی سختافزاری در حال توسعه هستند تا هزینهی آموزش مدلهای عمیق کاهش یابد.

۳. مشکل تفسیرپذیری و شفافیت

یکی از انتقادات جدی به یادگیری عمیق این است که مدلها اغلب مانند «جعبه سیاه» عمل میکنند. یعنی حتی توسعهدهندگان نمیدانند دقیقاً چرا یک مدل تصمیم خاصی گرفته است. این موضوع در حوزههایی مانند پزشکی یا سیستمهای قضایی بسیار خطرناک است، زیرا تصمیمهای مدل میتوانند تأثیر مستقیمی بر زندگی انسانها داشته باشند. اگر یک مدل تشخیص پزشکی به اشتباه بیماری را شناسایی نکند، نمیتوان صرفاً گفت «شبکه عصبی اینطور تصمیم گرفت». به همین دلیل، حوزهای به نام قابلیت تفسیر مدلها (Explainable AI) شکل گرفته است که هدف آن توسعه روشهایی برای توضیح تصمیمات مدل است. ابزارهایی مثل LIME و SHAP گامهایی مهم در این راستا هستند، اما هنوز مسیر طولانی برای شفافسازی کامل مدلهای عمیق باقی مانده است.

یادگیری ماشین در 4 قدم

قدم اول: آشنایی با مفاهیم پایهای

شروع یادگیری عمیق بدون شناخت مفاهیم اولیه تقریباً غیرممکن است. باید بدانید شبکه عصبی چیست، نورون مصنوعی چگونه ورودیها را وزندهی میکند و چرا وجود چندین لایه باعث «درک سلسلهمراتبی» از دادهها میشود. مفاهیمی مانند توابع فعالسازی (ReLU، Sigmoid)، الگوریتمهای بهینهسازی (مانند Gradient Descent) و مفاهیم آماری و جبری پایه ضروریاند. ریاضیات پایه—بهویژه جبر خطی و احتمال—به شما کمک میکند تا فرمولها و منطق پشت الگوریتمها را بهتر درک کنید.

مثال: اگر دادهای از قد و وزن افراد دارید، میتوانید با یک پرسپترون ساده (Single Neuron) پیشبینی کنید که فرد اضافهوزن دارد یا خیر. همین مثال ساده نشان میدهد چگونه ورودیها به خروجی تصمیم تبدیل میشوند.

قدم دوم: یادگیری عملی با ابزارها و کتابخانهها

پس از درک مبانی، باید سراغ ابزارهای عملی بروید. دو کتابخانه اصلی PyTorch و TensorFlow هستند که تقریباً همه پروژههای مدرن روی آنها بنا میشوند. در این مرحله یاد میگیرید دادهها را تمیز کنید، به مدل بدهید، شبکه عصبی طراحی کنید و سپس مدل را آموزش و تست کنید.

مثال: پروژه معروف MNIST یک نقطه شروع عالی است. این دیتاست شامل تصاویر سیاهوسفید اعداد دستنویس (۰ تا ۹) است. شما میتوانید یک شبکه کانولوشنی ساده (CNN) طراحی کنید تا اعداد را شناسایی کند. اجرای این پروژه، کل چرخه یادگیری عمیق—از آمادهسازی داده تا ارزیابی نتایج—را به شما نشان میدهد.

قدم سوم: کار روی پروژههای واقعی و تخصصی

وقتی روی پروژههای واقعی کار کنید، تازه با چالشهای اصلی روبهرو میشوید. دادههای واقعی معمولاً نویزی هستند، کلاسها نامتعادلاند، و نیاز به تنظیم دقیق ابرپارامترها دارید. انتخاب حوزهی تخصصی هم در این مرحله مهم است؛ میتوانید وارد بینایی ماشین، پردازش زبان طبیعی یا تحلیل گفتار شوید.

مثال: فرض کنید یک سیستم تشخیص چهره میسازید. باید دادههای چهرهی افراد مختلف را جمعآوری کنید، آنها را پیشپردازش کنید (مثلاً نرمالسازی نور و اندازه تصویر) و سپس یک مدل CNN عمیق آموزش دهید. در این مسیر یاد میگیرید چگونه با مشکلاتی مانند دادههای نامتعادل یا بیشبرازش مقابله کنید.

قدم چهارم: بهینهسازی، استقرار و یادگیری مداوم

مدل ساختهشده باید در محیط واقعی اجرا شود؛ اینجا استقرار (Deployment) اهمیت پیدا میکند. گاهی لازم است مدل روی موبایل اجرا شود، پس باید کوچک و سریع باشد. روشهایی مثل فشردهسازی مدل (Model Compression) یا استفاده از Transfer Learning کمک میکنند تا هزینه محاسباتی کاهش یابد. همچنین باید یاد بگیرید مدلهایتان را پایش کنید تا مطمئن شوید در طول زمان افت دقت ندارند.

مثال: فرض کنید یک اپلیکیشن موبایل برای تشخیص اشیاء ساختهاید. اگر مدل اصلی خیلی سنگین باشد، اجرا روی موبایل کند میشود. در این حالت میتوانید از مدلهای سبکتر مثل MobileNet استفاده کنید تا کارایی حفظ شود و در عین حال سرعت و مصرف انرژی مناسب باشد.

نتیجهگیری

یادگیری عمیق به عنوان یک فناوری انقلابی، نهتنها آیندهی هوش مصنوعی را شکل داده بلکه زندگی روزمرهی ما را دگرگون کرده است. تفاوت بنیادین آن با یادگیری ماشین سنتی در توانایی استخراج خودکار ویژگیهاست؛ قابلیتی که موجب شده در حوزههای مختلفی مثل بینایی ماشین، پردازش گفتار و خودروهای خودران پیشتاز باشد. با این حال، چالشهایی مثل نیاز به دادهی زیاد و منابع محاسباتی سنگین هنوز پابرجاست.

اگر به دنبال یادگیری بیشتر هستید، میتوانید از منابع معتبر زیر شروع کنید:

پرسش و پاسخ 1

شبکههای عمیق میلیونها پارامتر دارند که باید آموزش داده شوند. هرچه تعداد پارامترها بیشتر باشد، مدل ظرفیت بیشتری برای یادگیری الگوهای پیچیده دارد، اما در عین حال خطر «بیشبرازش» (Overfitting) نیز افزایش مییابد. برای جلوگیری از بیشبرازش، نیاز است که مدل روی مجموعه دادهی بسیار بزرگ و متنوعی آموزش ببیند تا بتواند تعمیمپذیر شود. به همین دلیل است که پروژههایی مانند ImageNet که شامل میلیونها تصویر برچسبخورده هستند، نقطهی عطفی در پیشرفت یادگیری عمیق محسوب میشوند.

چندین رویکرد برای کاهش هزینهها وجود دارد. انتقال یادگیری (Transfer Learning) یکی از پرکاربردترین روشهاست، که در آن یک مدل از پیش آموزشدیده روی دادههای عظیم، برای مسئلهای خاص تنظیم مجدد میشود. این روش نیاز به داده و محاسبات را به شدت کاهش میدهد. روش دیگر، فشردهسازی مدل (Model Compression) است که با حذف وزنهای غیرضروری یا کوانتایز کردن پارامترها، اندازه و سرعت مدل را بهینه میکند. همچنین، توسعهی سختافزارهای تخصصی مثل TPUهای گوگل، امکان آموزش سریعتر و کمهزینهتر را فراهم کرده است. پیشرفت یادگیری عمیق محسوب میشوند.